Odczytanie liter w systemie binarnym może wydawać się skomplikowane, ale w rzeczywistości jest to proces oparty na prostych zasadach. Komputery przedstawiają znaki, takie jak litery, jako liczby, które są następnie zapisywane w systemie binarnym. Najczęściej używanym standardem do przypisania liczb do znaków jest ASCII (American Standard Code for Information Interchange), który przypisuje unikalne wartości każdej literze, cyfrze i znakowi specjalnemu. Na przykład, litera 'A' ma wartość 65, a 'a' to 97 w systemie dziesiętnym.

W artykule omówimy, jak konwertować litery na kod binarny oraz jak odczytywać ciągi binarne jako tekst. Zrozumienie tego procesu jest kluczowe, aby lepiej pojąć, jak komputery przetwarzają informacje. Dzięki przedstawionym przykładom i wyjaśnieniom, każdy będzie mógł z łatwością zrozumieć, jak działa system binarny i jak wykorzystać go w praktyce.Kluczowe wnioski:

- Komputery reprezentują litery jako liczby, zapisane w systemie binarnym.

- Standard ASCII przypisuje unikalne wartości do każdej litery, co umożliwia ich konwersję na kod binarny.

- Każda litera jest reprezentowana przez bajt, czyli ciąg 8 bitów.

- Aby odczytać ciąg binarny, należy podzielić go na grupy po 8 bitów i przekonwertować na liczby dziesiętne.

- Unicode jest bardziej zaawansowanym standardem, który obsługuje tysiące znaków, w tym te z innych alfabetów.

Jak działa system binarny i jego znaczenie w informatyce

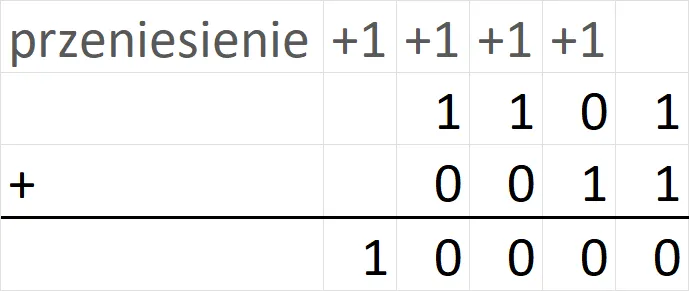

System binarny jest podstawowym sposobem reprezentacji danych w komputerach, opartym na dwóch cyfrach: 0 i 1. Każda informacja, niezależnie od tego, czy jest to tekst, obraz czy dźwięk, jest kodowana w formie binarnej, co umożliwia komputerom jej przetwarzanie. Dzięki temu systemowi, komputery mogą efektywnie przechowywać i przesyłać dane, co jest kluczowe w dzisiejszym cyfrowym świecie. Znajomość systemu binarnego jest niezbędna dla zrozumienia, jak działają różne technologie, od prostych aplikacji po skomplikowane systemy operacyjne. W kontekście informatyki, system binarny ma ogromne znaczenie, ponieważ jest podstawą dla wszelkich operacji logicznych i arytmetycznych. Komputery używają go do wykonywania obliczeń oraz do komunikacji między różnymi urządzeniami. Bez systemu binarnego, współczesne technologie, takie jak Internet, smartfony czy sztuczna inteligencja, byłyby niemożliwe do zrealizowania. Dlatego zrozumienie zasad działania systemu binarnego jest kluczowe dla każdego, kto chce zgłębiać tajniki informatyki.Zrozumienie podstawowych pojęć systemu binarnego

W systemie binarnym podstawowymi jednostkami informacji są bity i bajty. Bit to najmniejsza jednostka, która może przyjmować wartość 0 lub 1. Z kolei bajt składa się z 8 bitów i jest w stanie reprezentować 256 różnych wartości (od 0 do 255). Dzięki tej strukturze, komputery mogą przechowywać i przetwarzać różnorodne dane. Binary numbers są używane do kodowania informacji w sposób, który jest zrozumiały dla maszyn, a jednocześnie umożliwia ich przetwarzanie i analizę przez ludzi.

Dlaczego komputery używają systemu binarnego do reprezentacji liter

Komputery używają systemu binarnego do reprezentacji liter z kilku kluczowych powodów. Przede wszystkim, efektywność – system binarny pozwala na łatwe przetwarzanie danych w postaci zer i jedynek, co jest naturalne dla elektroniki komputerowej. Dodatkowo, kompatybilność z różnymi urządzeniami i systemami operacyjnymi jest znacznie ułatwiona, ponieważ większość z nich opiera się na tym samym standardzie binarnym. Dzięki temu, różne systemy mogą komunikować się ze sobą, co jest niezbędne w dzisiejszym zglobalizowanym świecie.

Jak konwertować litery na system binarny krok po kroku

Konwersja liter na system binarny jest procesem, który można zrealizować w kilku prostych krokach. Najpierw należy zidentyfikować wartość dziesiętną litery w standardzie ASCII. Na przykład, litera 'A' ma wartość 65. Następnie, tę wartość przekształcamy na system binarny. W przypadku 'A', wartość 65 w systemie binarnym to 01000001. Takie podejście umożliwia komputerom zrozumienie i przetwarzanie liter jako ciągów binarnych, co jest kluczowe dla ich funkcjonowania.

Warto zaznaczyć, że każda litera jest reprezentowana przez bajt, czyli ciąg 8 bitów. To oznacza, że każda litera, niezależnie od tego, czy jest to 'A', 'B', czy 'a', ma swoją unikalną reprezentację w systemie binarnym. Aby ułatwić zrozumienie, poniżej znajduje się lista najczęściej używanych liter i ich odpowiedników w systemie binarnym:

- A - 01000001

- B - 01000010

- C - 01000011

- a - 01100001

- b - 01100010

- c - 01100011

| Litera | Wartość ASCII | Reprezentacja binarna |

| A | 65 | 01000001 |

| B | 66 | 01000010 |

| C | 67 | 01000011 |

| a | 97 | 01100001 |

| b | 98 | 01100010 |

| c | 99 | 01100011 |

Wykorzystanie standardu ASCII do konwersji liter

Standard ASCII (American Standard Code for Information Interchange) jest kluczowym narzędziem w procesie konwersji liter na system binarny. ASCII przypisuje unikalne wartości dziesiętne dla każdej litery, cyfry i znaku specjalnego, co umożliwia ich łatwą reprezentację w postaci binarnej. Dzięki temu, każda litera, na przykład 'A', ma przypisaną wartość 65, która jest następnie przekształcana na kod binarny. W ten sposób, ASCII stanowi fundament dla wszystkich operacji związanych z tekstem w komputerach, umożliwiając ich przetwarzanie i interpretację w formie zrozumiałej dla maszyn.

Przykłady konwersji liter na kod binarny

Przykłady konwersji liter na kod binarny za pomocą standardu ASCII są niezwykle pomocne w zrozumieniu tego procesu. Na przykład, litera 'A' o wartości dziesiętnej 65 jest reprezentowana w systemie binarnym jako 01000001. Podobnie, litera 'B' (66) to 01000010, a 'C' (67) to 01000011. Każda litera ma swoją unikalną reprezentację, co pozwala komputerom na ich rozpoznawanie i przetwarzanie. Poniżej znajduje się tabela z przykładami liter i ich binarnymi odpowiednikami:

| Litera | Wartość ASCII | Reprezentacja binarna |

| A | 65 | 01000001 |

| B | 66 | 01000010 |

| C | 67 | 01000011 |

| a | 97 | 01100001 |

| b | 98 | 01100010 |

| c | 99 | 01100011 |

Czytaj więcej: Co to jest system binarny i dlaczego jest kluczowy w technologii?

Jak odczytać ciąg binarny jako tekst i jego znaczenie

Odczytanie ciągu binarnego jako tekst jest kluczowym procesem w informatyce, który pozwala na interpretację danych zapisanych w systemie binarnym. Aby to zrobić, należy podzielić ciąg binarny na grupy po 8 bitów, co odpowiada jednemu bajtowi. Następnie każdy bajt jest konwertowany na wartość dziesiętną, a ta wartość jest używana do identyfikacji odpowiadającego mu znaku w tabeli ASCII. Dzięki temu procesowi, komputery mogą przetwarzać i wyświetlać tekst w formie zrozumiałej dla użytkowników.

Znajomość tego procesu jest niezwykle ważna, ponieważ umożliwia efektywne zarządzanie danymi w różnych aplikacjach i systemach. Na przykład, podczas przesyłania danych w sieci, informacje są często kodowane w formie binarnej, a ich dekodowanie pozwala na ich odczytanie przez użytkowników. Odczyt ciągów binarnych jest zatem niezbędny do zrozumienia, jak działają nowoczesne technologie informacyjne oraz jak można je wykorzystać w praktyce.

Proces dekodowania binarnego na litery i znaki

Proces dekodowania binarnego na litery i znaki jest prosty, ale wymaga kilku kroków. Po pierwsze, należy podzielić ciąg binarny na bajty, co oznacza grupowanie bitów w zestawy po 8. Następnie każdy bajt konwertuje się na wartość dziesiętną, wykorzystując standard ASCII. Na przykład, bajt 01101000 odpowiada wartości 104, co w tabeli ASCII oznacza literę 'h'. Po zidentyfikowaniu wszystkich bajtów w ciągu, można odczytać pełny tekst, co pozwala na interpretację przesyłanych danych. Dzięki tym krokom, komputery mogą efektywnie przetwarzać i wyświetlać tekst, co jest kluczowe w komunikacji cyfrowej.

Przykłady odczytu ciągów binarnych w praktyce

Odczyt ciągów binarnych na tekst jest kluczowy w informatyce. Na przykład, ciąg binarny 01101000 01100101 01101100 01101100 01101111 odpowiada słowu "hello". Kolejny przykład to ciąg 01000111 01101111 01101111 01100100 01100010 01111001 01100101, który dekoduje się jako "Goodbye". Jeszcze jeden przykład to 01001110 01100101 01110111, który oznacza "New". Te przykłady pokazują, jak ciągi binarne mogą być przekształcane w zrozumiały tekst, co jest niezbędne w komunikacji cyfrowej.

Inne standardy kodowania liter i ich zastosowanie

Oprócz standardu ASCII, istnieją inne systemy kodowania, które są używane do reprezentacji liter i znaków w różnych językach. Unicode to jeden z najważniejszych standardów, który został stworzony, aby umożliwić reprezentację tysiąca różnych znaków z różnych alfabetów. Dzięki Unicode, można używać znaków z takich języków jak chiński, arabski czy cyrylica, co jest niezwykle istotne w globalnej komunikacji i tworzeniu oprogramowania, które obsługuje wiele języków.

Unicode nie tylko zwiększa zakres dostępnych znaków, ale także zapewnia spójność w ich reprezentacji na różnych platformach i urządzeniach. W przeciwieństwie do ASCII, który ogranicza się do 128 znaków, Unicode może reprezentować ponad 143,000 znaków, co czyni go bardziej uniwersalnym i elastycznym standardem. Dzięki temu, programiści i twórcy treści mogą łatwiej tworzyć aplikacje i strony internetowe, które są dostępne dla szerokiego grona użytkowników na całym świecie.

Wprowadzenie do standardu Unicode i jego znaczenie

Unicode jest standardem kodowania, który ma na celu ułatwienie komunikacji między różnymi systemami i językami. Jego celem jest zapewnienie, że każdy znak, niezależnie od języka czy platformy, będzie reprezentowany w ten sam sposób. Dzięki Unicode, programiści nie muszą martwić się o to, czy ich aplikacja będzie poprawnie wyświetlać znaki z różnych języków, co jest kluczowe w dobie globalizacji. W ten sposób, Unicode nie tylko wspiera różnorodność językową, ale także ułatwia współpracę międzynarodową i rozwój technologii informacyjnych.

Przyszłość kodowania: Jak AI zmienia interpretację binarną

W miarę jak technologia się rozwija, sztuczna inteligencja (AI) zaczyna odgrywać kluczową rolę w interpretacji danych binarnych. Dzięki zaawansowanym algorytmom uczenia maszynowego, AI ma zdolność do analizy ogromnych zbiorów danych, co pozwala na bardziej efektywne dekodowanie i przetwarzanie informacji. Przykładem może być wykorzystanie AI do automatycznego rozpoznawania tekstu z obrazów lub wideo, gdzie ciągi binarne są przekształcane w zrozumiały tekst, co otwiera nowe możliwości w dziedzinie analizy danych i interakcji z użytkownikami.

Co więcej, technologie oparte na AI mogą również przyczynić się do rozwoju nowych standardów kodowania, które będą bardziej uniwersalne i dostosowane do potrzeb użytkowników. Dzięki AI, możliwe będzie tworzenie inteligentnych systemów, które będą w stanie uczyć się i dostosowywać do różnych języków i alfabetów, co może zrewolucjonizować sposób, w jaki przetwarzamy i interpretujemy informacje w przyszłości. Tego rodzaju innowacje mogą znacząco wpłynąć na globalną komunikację i dostępność treści w różnych językach, co jest kluczowe w zglobalizowanym świecie.